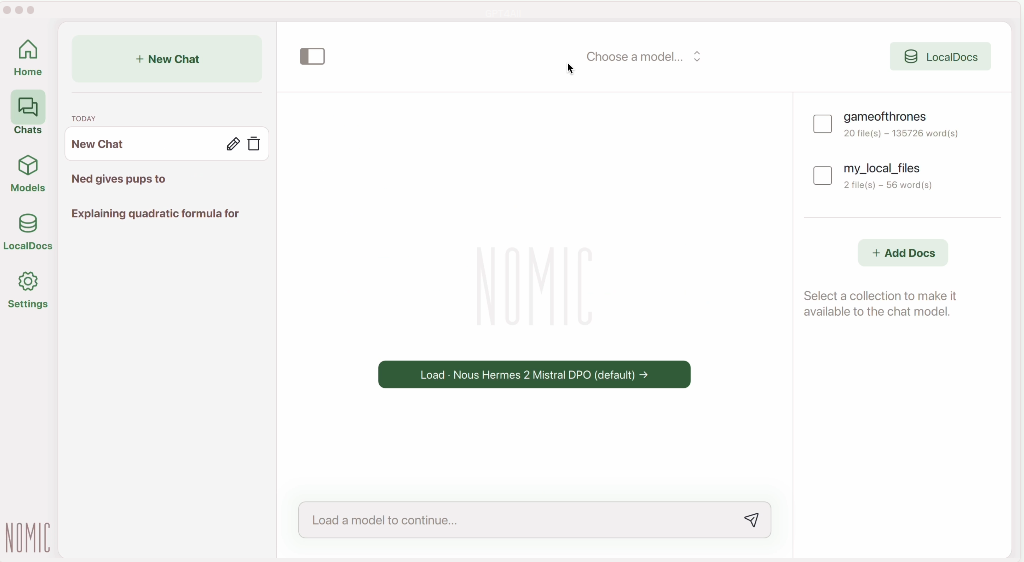

OpenAI ha recentemente annunciato un importante miglioramento del suo modello linguistico GPT-4o. L’azienda ha presentato una versione sperimentale denominata GPT-4o Long Output, capace di generare risposte fino a 64000 token, quadruplicando la capacità precedente per il modello più veloce.

GPT-4o si espande output fino a 64000 token, e capacità visive su GPT-4o mini

Microsoft ha annunciato l’integrazione di GPT-4o mini con supporto per la visione artificiale nelle sue implementazioni standard in alcune regioni. Questa innovazione consente agli sviluppatori di utilizzare le API per elaborare immagini e video in applicazioni che richiedono riconoscimento visivo e comprensione delle scene. GPT-4o mini non si limita all’analisi visiva, ma può generare descrizioni testuali dettagliate e contestualmente pertinenti a partire da input visivi.

I clienti Azure possono già provare GPT-4o mini tramite Azure OpenAI Studio Playground, scoprendo le potenzialità di questa avanzata tecnologia. L’integrazione di capacità visive in un modello linguistico già potente segna un notevole progresso nel campo dell’intelligenza artificiale e l’evoluzione di GPT-4o sottolinea la rapidità con cui il settore dell’IA sta avanzando, specialmente nei modelli linguistici e di visione artificiale.

I token nelle intelligenze artificiali

In ambito di intelligenza artificiale, soprattutto nel contesto dell’elaborazione del linguaggio naturale (NLP, Natural Language Processing), il termine “token” ha un significato specifico e importante. Ecco una definizione dettagliata:

Definizione di Token in Intelligenza Artificiale

Un token è una sequenza di caratteri considerata come un’unità discreta per scopi di elaborazione. Nel contesto dell’elaborazione del linguaggio naturale, i token sono solitamente parole, ma possono anche essere caratteri, sottoparole o frasi intere a seconda dell’applicazione e del modello utilizzato.

Tokenizzazione

La tokenizzazione è il processo di suddividere un testo in token. È un passaggio fondamentale nel pre-processing dei dati testuali per vari compiti di NLP come l’analisi del testo, la traduzione automatica, il riconoscimento del linguaggio e la generazione di testo.

Tipi di Token

- Word Token: Ogni parola è considerata un token. Ad esempio, la frase “Il gatto corre” viene tokenizzata come [“Il”, “gatto”, “corre”].

- Character Token: Ogni carattere è considerato un token. Ad esempio, la stessa frase viene tokenizzata come [“I”, “l”, ” “, “g”, “a”, “t”, “t”, “o”, ” “, “c”, “o”, “r”, “r”, “e”].

- Subword Token: Le parole possono essere suddivise in unità più piccole come prefissi, suffissi o altre sottoparti. Questo è comune nei modelli basati su BPE (Byte Pair Encoding) o WordPiece. Ad esempio, “corso” potrebbe essere tokenizzata in [“cor”, “so”].

- Sentence Token: Intere frasi sono considerate token.

Utilizzo dei Token

- Input ai Modelli di AI: I modelli di linguaggio, come GPT (Generative Pre-trained Transformer) e BERT (Bidirectional Encoder Representations from Transformers), utilizzano token come input per elaborare e generare testo.

- Rappresentazione e Embedding: I token vengono trasformati in vettori numerici (embedding) che i modelli possono utilizzare per il calcolo.

- Calcolo della Probabilità: Nei modelli di linguaggio probabilistici, la probabilità di occorrenza di un token dato il contesto viene calcolata per generare testo o fare previsioni.

Vantaggi della Tokenizzazione

- Riduzione della Complessità: Trasformando il testo in unità discrete, si semplifica l’elaborazione e l’analisi del linguaggio.

- Flessibilità: Permette di applicare modelli statistici e di apprendimento automatico al testo.

- Efficienza: Riduce la dimensionalità del problema rispetto al trattare direttamente il testo grezzo.